E-Mail: [email protected]

- L'adozione di algoritmi nei concorsi pubblici per la selezione del personale ha sollevato questioni di trasparenza.

- La giurimetria, come disciplina emergente, mira a migliorare la previsione delle sentenze e la coerenza delle decisioni giudiziarie.

- La normativa europea (GDPR) pone l'accento sulla trasparenza delle decisioni algoritmiche, ma l'applicazione pratica rimane complessa.

L’introduzione dell’intelligenza artificiale (IA) nei sistemi giuridici ha determinato una trasformazione significativa nel modo in cui vengono affrontate le questioni legali, ridefinendo concetti tradizionali e sollevando nuove problematiche etiche e legali. L’IA, capace di analizzare enormi quantità di dati in tempi ridotti, promette di accelerare il lavoro legale, ma pone anche delle questioni cruciali in termini di sicurezza e trasparenza. In contesti come i procedimenti di selezione del personale, ad esempio, sono stati adottati algoritmi per automatizzare la selezione dei candidati nei concorsi pubblici. Questi algoritmi, pur offrendo potenzialmente maggiore efficienza e imparzialità, mancano spesso di trasparenza nelle loro decisioni, scatenando controversie quando le decisioni sembrano ingiuste o errate.

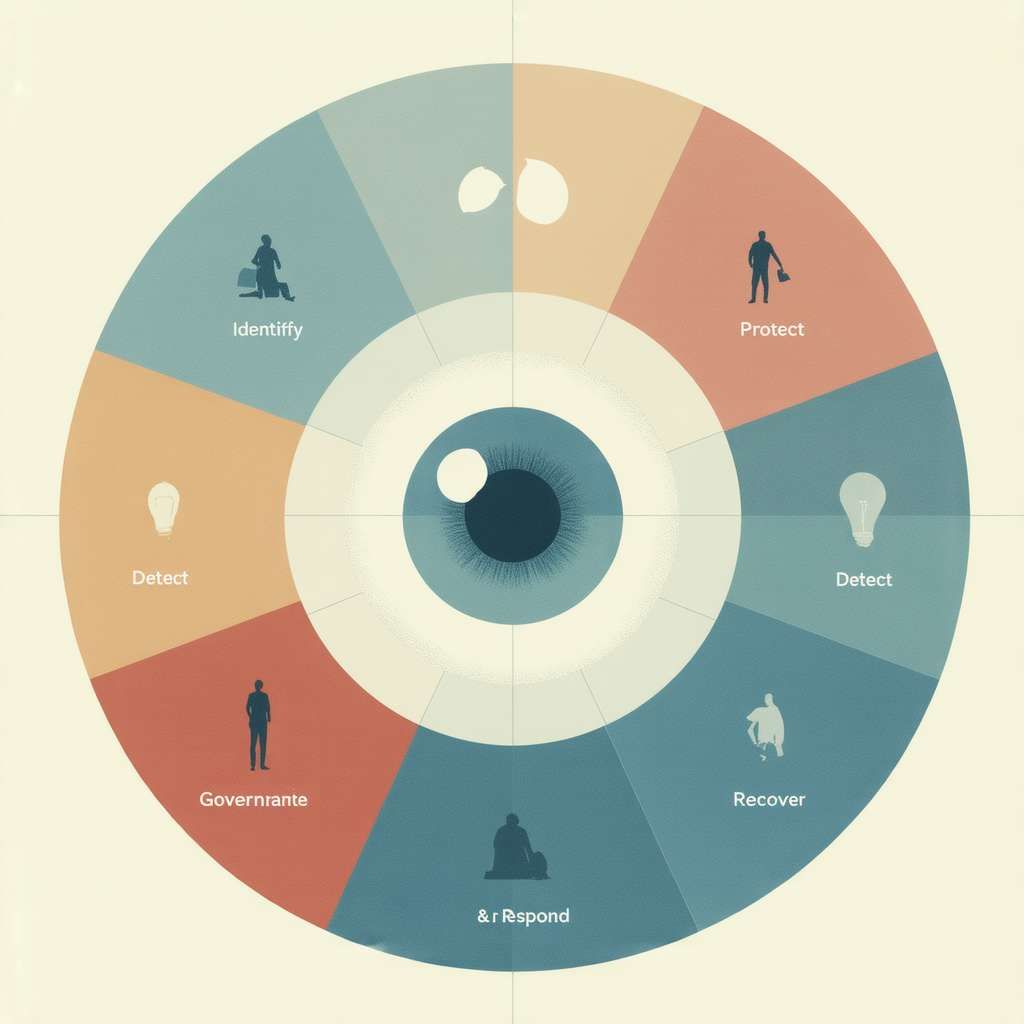

Una delle maggiori sfide è rappresentata dalla “spiegabilità” delle decisioni algoritmiche: i sistemi giuridici stanno cercando di conciliare la tecnologia avanzata con il bisogno di chiarezza e comprensibilità delle decisioni prese. La spiegabilità, infatti, permette di comprendere il razionale dietro a scelte che incidono profondamente sulle vite delle persone, mantenendo un equilibrio necessario tra automazione e giustizia. Un elemento chiave che emerge è la “giurimetria”, ovvero l’uso di statistica e analisi quantitativa nel diritto, che si affaccia come una disciplina emergente, volta a perfezionare la previsione delle sentenze e migliorare la coerenza delle decisioni giudiziarie.

chi controlla gli algoritmi? Analisi delle responsabilità

Il controllo sugli algoritmi e sull’intelligenza artificiale è al centro di un dibattito acceso. A livello globale, aziende tecnologiche come Facebook sono al centro di polemiche per la gestione dei loro algoritmi, che influenzano comportamenti e decisioni degli utenti in modi che talvolta sfuggono al controllo umano. La questione del “chi” abbia potestà di controllo su tali strumenti si intreccia con la questione delle responsabilità legali derivanti da eventuali errori o abusi.

Un esempio paradigmatico è rappresentato dagli algoritmi di raccomandazione usati dai social media, che mettono in evidenza come l’engagement sia spesso perseguito a scapito della veridicità e dell?integrità informativa. In questi scenari, i responsabili dello sviluppo degli algoritmi affrontano sfide legate alla polarizzazione dei contenuti, dove le linee guida che regolano la responsabilità legale sono ancora vaghe e variabili. Inoltre, la crescita della portata algoritmica solleva la questione della collettivizzazione della responsabilità, per cui le funzioni prima attribuibili a singoli individui ora sono distribuite tra più unità operative, complicando ulteriormente l?individuazione di colpevoli.

- 🌟 L'IA giuridica promette un futuro più equo......

- ⚠️ Preoccupante mancanza di trasparenza negli algoritmi di giustizia......

- 🔍 E se gli algoritmi fossero i nuovi giudici?... ...

trasparenza e protezione dei dati: sfide e normative

La protezione dei dati e la trasparenza nelle decisioni algoritmiche sono questioni centrali nel dialogo sul diritto digitale. La legislazione europea, attraverso il GDPR, ha stabilito delle norme volte a tutelare la privacy degli individui e a garantire la possibilità per le persone di comprendere e contestare decisioni basate su processi automatizzati. Tuttavia, nonostante queste normative esistano, la loro applicazione pratica è complessa e suscettibile di miglioramenti.

Un esempio significativo riguarda l’uso di algoritmi nelle assegnazioni delle sedi per gli insegnanti in Italia, dove la mancanza di trasparenza ha portato a numerose dispute legali. Le contestazioni legate a decisioni algoritmiche emerse in questi casi esemplificano i rischi connessi all’affidamento esclusivo alla tecnologia per funzioni delicate senza una supervisione umana adeguata. La necessità di assicurarsi che gli algoritmi siano giusti, trasparenti e liberi da pregiudizi è particolarmente pressante in settori in cui le decisioni hanno impatti diretti e significativi sulla vita delle persone.

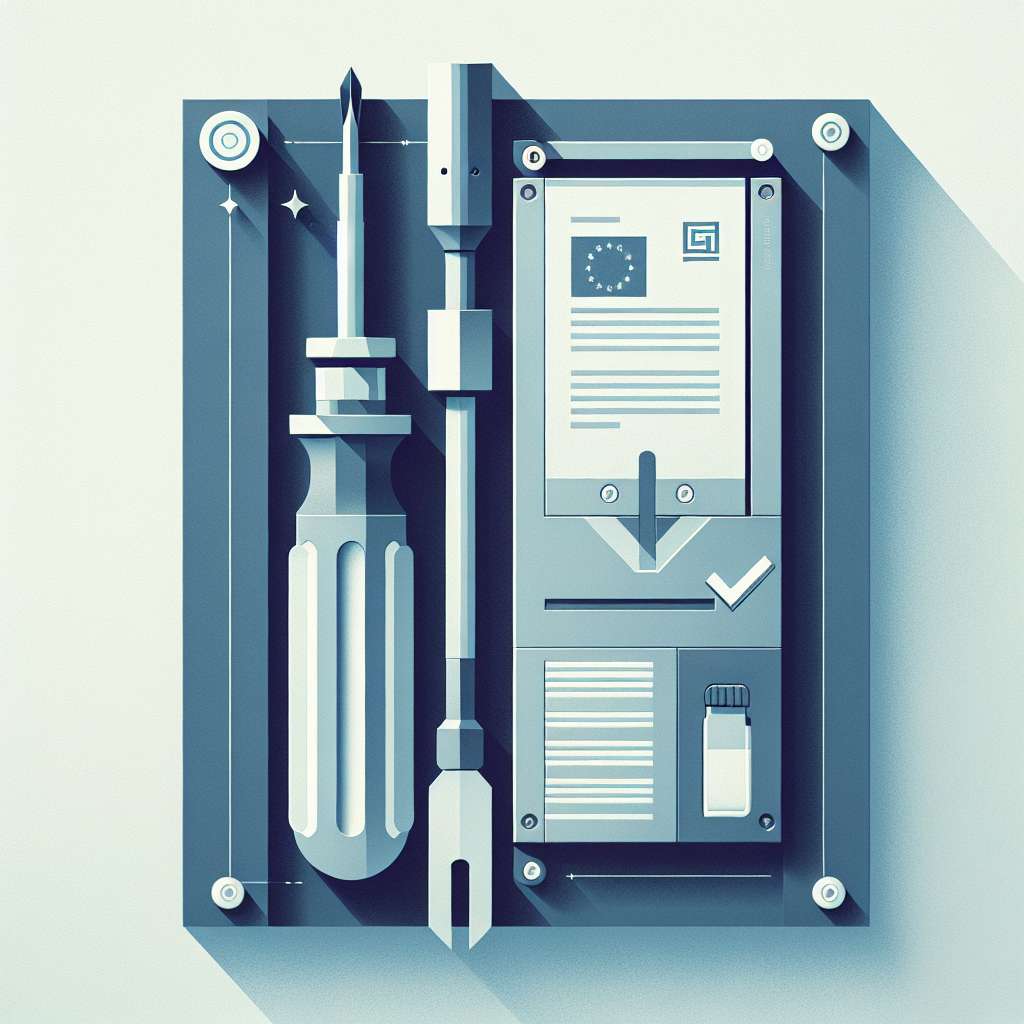

Per garantire uno sviluppo etico e responsabile dell’IA, sono in discussione nuove proposte, incluse quelle per la creazione di un registro pubblico delle decisioni algoritmiche, che renderebbero tali decisioni più tracciabili e verificabili. In parallelo, una forma di “certificazione di spiegabilità” dei sistemi IA viene vista come una possibile soluzione per garantire che le tecnologie utilizzate soprattutto in ambito pubblico siano trasparenti e auditate accuratamente.

verso un nuovo equilibrio tra tecnologia e diritti

Nell’attuale scenario giuridico-tecnologico, la necessità di stabilire un equilibrio tra innovazione e tutela dei diritti fondamentali diviene sempre più urgente. L’evoluzione della tecnologia IA, così come l’adozione di algoritmi in aree chiave della pubblica amministrazione, pone di fronte a questioni mai affrontate prima, che coinvolgono i diritti degli individui e la necessità di aggiornare le normative esistenti.

Una nozione legale di base che emerge è il principio del diritto alla spiegazione, secondo cui, in accordo con il GDPR, ogni individuo deve avere il diritto di comprendere pienamente le decisioni che lo riguardano e che sono prese da algoritmi. Questo principio non solo promuove la trasparenza, ma si pone anche come una salvaguardia contro errori o decisioni discriminatorie.

Sul fronte delle nozioni legali avanzate, si delinea il concetto di “responsabilità algoritmica”, che esplora come possano essere definite le responsabilità legali per danni causati da sistemi automatizzati. Un’area complessa e in continua evoluzione, dove il mix tra tecnologia e diritto esige interpretazioni chiare e precisa definizione delle responsabilità.

In definitiva, il dibattito attorno all’intelligenza artificiale nel contesto giuridico non è solo una questione di progresso tecnologico ma di come questo progresso possa essere integrato nel tessuto normativo per rafforzare la giustizia e tutelare i diritti umani. In quest’ottica, è necessario un ampio dialogo tra esperti giuridici, tecnici e politici per delineare una governance dell?IA che risponda alle sfide attuali e tuteli con efficacia i diritti dei cittadini davanti ai progressi della tecnologia.